Controle de taxa de API: limitação prática e prevenção de abusos

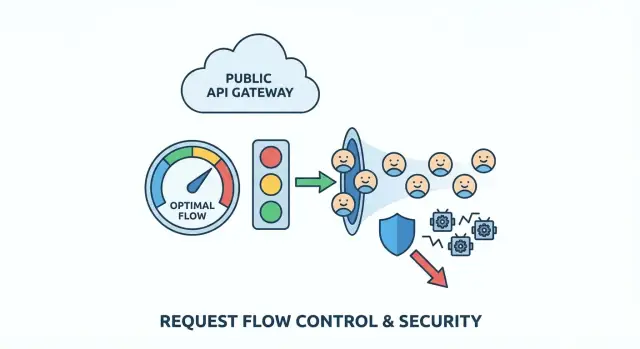

Padrões de limitação de taxa para APIs que regulam tráfego, barram bots e estabelecem cotas justas por usuário com regras simples que protegem clientes reais.

Qual problema você está resolvendo (em termos simples)

Uma API pública é como uma recepção que nunca fecha. A maioria das pessoas chega, pede uma coisa e vai embora. Abuso é quando alguém (ou um código com bug) fica martelando essa recepção tão frequentemente que todo mundo fica esperando.

Abuso raramente é só uma coisa. Pode ser scraping (puxar muitos dados rapidamente), tentativas de força bruta (adivinhar senhas ou chaves de API), ou um cliente fora de controle que faz retries em loop após um erro. Às vezes nem é mal-intencionado: um deploy ruim pode transformar um app normal no seu maior “atacante”.

É tentador “bloquear tudo”, mas regras grosseiras punem usuários reais. Muitos clientes compartilham IP (escritórios, escolas, cafés). Redes móveis trocam IPs. Alguns SDKs fazem retries automaticamente. Se sua regra for ampla demais, você bloqueia as pessoas erradas e ainda perde o verdadeiro abusador.

Sinais precoces aparecem em logs e painéis: picos de tráfego que não batem com o uso normal, aumento de erros (timeouts, 429, 5xx), respostas mais lentas, uma mistura estranha de endpoints (um endpoint de lista chamado milhares de vezes por minuto), ou muitas falhas de autenticação e requisições “quase válidas”.

O objetivo da limitação de taxa de API é simples: manter a API disponível e previsível para usuários normais, mesmo quando o tráfego fica bagunçado. Bons limites desaceleram padrões ruins, dão feedback claro a clientes legítimos e lhe compram tempo para responder sem derrubar todo o serviço.

Mapeie suas superfícies de API e pontos de risco

Antes de escolher números, fique claro sobre o que você está protegendo. Limitação de taxa funciona melhor quando corresponde ao formato real da sua API, não a uma regra única e geral.

Comece listando todo ponto de entrada público que terceiros podem atingir, inclusive os que você esquece porque “parecem internos” (endpoints móveis, chamadas JSON do app web, rotas de parceiros). Marque quais endpoints são suscetíveis a abuso e quais são simplesmente caros.

Áreas de alto risco geralmente são previsíveis: login, cadastro, refresh de token, reset de senha e códigos de verificação, endpoints de busca/filtragem caros, uploads ou processamento de mídia, e qualquer ação parecida com admin que acabou exposta por engano.

Em seguida, decida a quem um limite se aplica:

- Tráfego anônimo muitas vezes precisa de limites por IP, mas IPs são compartilhados e podem rotacionar.

- Tráfego autenticado pode usar ID de usuário, chave de API, cliente OAuth ou ID de organização/workspace.

- Produtos B2B normalmente se beneficiam de limites a nível de organização para que um cliente não possa deixar todos os outros sem recursos.

Para manter gerenciável, classifique endpoints por “custo” para não tratar tudo igual. Por exemplo: leituras baratas, listas normais com paginação, buscas/exports/uploads/ chamadas de IA custosas, e fluxos críticos de autenticação/senha.

Depois defina uso justo em palavras simples. Você se importa com picos curtos (100 requisições em 10 segundos) ou com drenagem contínua (10.000 por dia)? Muitos produtos precisam de ambos: um pequeno burst para carregamento de páginas, mais um limite maior para impedir scraping lento.

Se você herdou uma API gerada por IA, faça esse mapeamento primeiro. Times como FixMyMess frequentemente encontram endpoints “caros” escondidos atrás de nomes inocentes, além de checks de autenticação ausentes que transformam limitação de taxa na sua última linha de defesa.

Escolha um modelo de throttling que combine com o tráfego real

Bom rate limiting deve ser invisível para usuários normais e muito ruidoso para abusadores. Isso geralmente significa suportar comportamento em burst (carregamento de páginas, reconexões móveis, retries) sem permitir extração sustentada de alto volume.

Os modelos principais (e quando se encaixam)

Token bucket é a escolha comum de “boa UX”. Cada usuário tem um balde que se reabastece ao longo do tempo. Cada requisição gasta um token. Se o balde estiver cheio, usuários podem fazer um burst rápido e depois desacelerar naturalmente conforme os tokens acabam.

Leaky bucket é mais rigoroso. Requisições entram num funil que drena em velocidade constante. Suaviza bem picos, o que protege backends frágeis, mas pode ser severo para clientes legítimos que fazem bursts normais (abrir várias páginas rapidamente).

Fixed window é o mais simples: “100 requisições por minuto.” O problema é a borda. Um cliente pode fazer 100 requisições em 12:00:59 e 100 em 12:01:00, o que dá na prática 200 requisições em dois segundos. Às vezes é aceitável para endpoints de baixo risco ou como primeira medida quando simplicidade importa mais que justiça.

Na prática, muitos times padronizam um modelo padrão e têm uma opção mais rigorosa para endpoints sensíveis:

- Padrão: token bucket para a maioria das APIs de leitura/escrita

- Mais rígido: leaky bucket (ou token bucket com um burst muito pequeno) para rotas caras

- Opção simples: fixed window para endpoints de baixo impacto

- Regras separadas para autenticação, busca e ações em lote

Isso mantém a política simples enquanto protege de fato as rotas que atacantes miram.

Decida sobre o que você aplica limites (e o que evitar)

Limitação de taxa só é justa quanto o identificador que você escolhe. Se escolher o “quem” errado, você bloqueia bons usuários enquanto abusadores passam.

A opção mais limpa é uma chave de API (ou cliente OAuth) porque mapeia para um cliente real e não é compartilhada por acidente. Um ID de usuário autenticado também é forte, mas pode complicar quando uma pessoa abre muitas sessões ou troca dispositivos. Um ID de org/workspace ajuda a fazer cumprir limites de plano, mas pode esconder um usuário barulhento dentro de uma conta grande.

Limites por IP funcionam antes do login, mas também punem inocentes porque IPs são compartilhados por natureza (escritórios, escolas, operadoras móveis). Se você confiar só em IP, um usuário pesado pode bloquear um campus inteiro.

Uma abordagem mais segura é combinar sinais para que nenhum domine sozinhos:

- Por usuário ou por chave de API: protege clientes uns dos outros

- Por IP: pega inundações e bots baratos cedo

- Por endpoint: limites mais rígidos em rotas caras (login, busca, exports)

- Por org: aplica limites de plano sem microgerenciar indivíduos

Para tráfego não autenticado, assuma risco maior. Mantenha tetos mais estritos, mas dê um caminho para confiança maior: permita pequenos bursts, depois desacelere e incentive autenticação antes de ações de alto volume.

Exemplo: para um endpoint público search, limite por chave de API e por IP. Assim um scraper que rota chaves ainda bate num muro por IP, e um cliente real em um escritório compartilhado ainda tem seu orçamento por chave.

Se você herdou código gerado por IA, verifique se os identificadores são consistentes entre serviços. FixMyMess costuma ver limites atrelados a valores instáveis (como headers crus), o que faz o throttling parecer aleatório para clientes.

Passo a passo: implementar limites sem quebrar clientes

Limitação de taxa funciona melhor quando é previsível para usuários reais e dolorosa apenas para abusadores. Você não quer bloquear tráfego; quer moldá-lo.

1) Comece com níveis e regras simples

Defina alguns níveis que batam com o uso real: visitantes anônimos, usuários logados gratuitos, usuários pagos e ferramentas internas. Mantenha a primeira versão simples. Você pode adicionar nuances depois.

2) Pondere endpoints por risco (e custo)

Nem todas as requisições são iguais. Faça endpoints caros ou sensíveis custarem mais que leituras básicas. Login, reset de senha, busca e export são ímãs comuns para abuso.

Uma abordagem prática é requisições ponderadas: leituras custam 1, login custa 5–10, exports custam 50+, e qualquer coisa que dispare trabalho pesado no banco custa mais. Isso desacelera scraping e força bruta sem punir navegação normal.

3) Retorne 429 claros e cabeçalhos consistentes

Quando um cliente atingir o limite, responda com HTTP 429 e uma mensagem simples dizendo o que aconteceu e o que fazer a seguir. Inclua cabeçalhos consistentes para que clientes se autoajustem. Se sua stack suportar, envie cota restante, tempo até reset e um Retry-After.

4) Dê orientações seguras de retry

Seja explícito sobre quando retry é razoável (pequenos bursts) e quando não é (cotas rígidas, ou endpoints como login onde retries repetidos parecem ataque). Comportamento ruim de retry pode transformar um pequeno pico numa séria ocorrência.

5) Monitore e ajuste com dados reais

Acompanhe quantas vezes usuários atingem limites, quais endpoints geram 429s e quais identidades são os maiores ofensores. Se você estiver consertando uma app gerada por IA (por exemplo, um protótipo com auth quebrada e retries barulhentos), frequentemente encontrará loops acidentais no cliente que parecem abuso. Corrigir o cliente muitas vezes reduz o incômodo dos limites mais do que aumentá-los.

Padrões de proteção contra bots que não punem usuários normais

Boa proteção contra bots é menos construir um muro e mais colocar pequenas lombadas onde bots extraem mais valor: signup, reset de senha e refresh de token. Usuários normais atingem esses pontos raramente, então checagens extras incomodam menos.

Antes de desafiar alguém, registre sinais que separam automação ruim de comportamento normal: picos de contas novas de um intervalo de IP, tentativas repetidas de login ou reset, refresh de token sem uso real da API depois, user agents incomuns, ou tráfego que só toca endpoints de lista/busca.

Use desafios progressivos em vez de banir instantaneamente. Comece com um 429 claro e um cooldown curto. Se o padrão continuar, desacelere o cliente e depois bloqueie por um curto período (minutos, não dias). Isso reduz a chance de você derrubar um Wi‑Fi de cafeteria onde vários usuários reais compartilham um IP.

Trate credential stuffing diferente de picos gerais de API. Para login, limite por identificador de conta + IP, e use limiares mais baixos para tentativas falhas. Para tráfego geral de API, mantenha limites mais tolerantes e foque em padrões sustentados e repetitivos.

Cotas por usuário e regras de uso justo

Limites por minuto impedem picos, mas não respondem à questão de justiça: quem consome mais ao longo do tempo? Cotas por usuário (ou por organização) limitam o uso total por dia ou mês, para que um cliente pesado não ocupe tudo silenciosamente.

Comece com uma unidade que as pessoas entendam: requisições por dia, tokens por mês ou “jobs” por ciclo de cobrança. Em produtos de equipe, cotas costumam ficar no nível da organização com sub-limites por usuário, para que um colega não queime toda a cota.

Limites suaves evitam falhas-surpresa. Um padrão simples: notifique em 80%, avise em 95%, bloqueie em 100%. Mesmo sem sistema de cobrança, esses limiares ajudam clientes a se ajustar antes de falhar.

Quando alguém ultrapassa a cota, faça a resposta óbvia e acionável. Use um status claro (muitas vezes 429) e inclua uso atual, limite, tempo até reset e como pedir aumento.

Um exemplo concreto: se um app gerado por IA for lançado sem cotas, uma chave de API vazada pode consumir uma semana de uso em horas. Times como FixMyMess geralmente veem isso após um protótipo ir ao ar. Adicionar limites mensais a nível de org mais avisos antecipados normalmente detém o dano sem bloquear clientes legítimos que simplesmente precisam de um plano maior ou um aumento temporário.

Onde os limites vivem: escolhas de arquitetura que aguentam em produção

Onde você aplica limites importa tanto quanto os números que escolhe. A mesma regra pode ser confiável ou inútil dependendo de onde o contador vive e como é atualizado.

A maioria dos times aplica limites em um destes lugares:

- Em memória (por servidor): rápido e simples, mas falha com múltiplas instâncias

- Redis (cache compartilhado): padrão comum, compartilhado entre instâncias, suporta updates atômicos

- Banco de dados: mais fácil de auditar, mas geralmente lento e caro para checagens por requisição

- API gateway ou recursos do CDN: ótimos quando disponíveis, mas podem ser limitantes para chaves personalizadas e respostas customizadas

Se estiver em dúvida, Redis com um pequeno wrapper no app é um ponto de partida seguro para APIs públicas.

Realidades distribuídas e multi-região

Em sistemas distribuídos, condições de corrida são um modo silencioso de falha. Duas requisições podem passar na checagem ao mesmo tempo a não ser que seu increment-and-compare seja atômico. Use incrementos atômicos (ou um script/transação única) e mantenha chaves consistentes, como userId + route + time window. Chaves inconsistentes criam brechas que abusadores encontram rápido.

Tráfego multi-região força um tradeoff entre aplicação estrita e disponibilidade. Limites globais estritos exigem um contador compartilhado ou coordenação forte, o que adiciona latência e pode falhar em estado fechado. Muitos times aceitam limites “soft” por região (consistência eventual) porque isso mantém a API responsiva e ainda impede a maior parte do abuso.

Evite bater no seu banco principal só para decidir permitir uma requisição. Rate limiting deve ser uma busca rápida, e sua lógica de negócio deve rodar somente se a requisição for permitida.

Se você herdou um backend gerado por IA (comum com ferramentas como Replit ou v0), aqui é onde frequentemente as coisas dão errado: limites são armazenados em processo, resetam no deploy e falham assim que você escala.

Erros e armadilhas comuns

A maioria dos rollouts que falham não vem de atacantes sofisticados. Acontecem porque limites são muito simples, muito grosseiros ou invisíveis depois do deploy.

Uma armadilha comum é definir um único limite global e achar que está pronto. Parece seguro, mas pune seus melhores clientes (power users, parceiros) e suas próprias ferramentas internas. Separe classes de tráfego (público, autenticado, parceiro, interno) e dê tetos diferentes.

Outra armadilha é confiar apenas em limites por IP. IPs são compartilhados e rotacionam. Se você bloquear por IP sozinho, vai bloquear inocentes e ainda perder bots distribuídos.

Fique atento a tempestades de retry. Um cliente recebe 429, tenta de novo imediatamente, recebe 429 de novo e multiplica o tráfego no pior momento. Sua resposta 429 deve tornar o backoff a escolha óbvia.

Também repare em auto‑throttling: seu frontend chama sua API durante um lançamento enquanto jobs em background também chamam para sincronizar. Se ambos compartilham a mesma chave ou token, podem se atrapalhar e criar falhas aleatórias.

Não opere no escuro. Se você não consegue ver quais usuários, chaves, intervalos de IP ou endpoints disparam throttles, não consegue ajustar regras antes dos clientes reclamarem.

Checklist rápido antes do lançamento

Antes de habilitar limites para todos, faça uma rodada rápida nos pontos que costumam causar dor:

- Separe tráfego em pelo menos dois buckets: anônimo (maior risco) e logado (mais identificável).

- Faça endpoints sensíveis mais rígidos que leituras normais: fluxos de auth, reset de senha, refresh de token, signup e buscas/relatórios/exports caros.

- Faça respostas 429 claras: linguagem simples +

Retry-Afterpara que clientes bem comportados recuem. - Adicione monitoramento antes do lançamento: principais ofensores (key/IP/usuário) e endpoints mais bloqueados.

- Planeje exceções: suporte precisa de um caminho seguro de override temporário com logging.

Cenário de exemplo: parar scraping sem bloquear clientes reais

Você tem um endpoint público de busca como GET /search?q=.... Funciona bem até um scraper começar a paginar todas as combinações de palavras-chave e filtros o dia inteiro. Clientes reais ainda usam o serviço, mas sua API gasta a maior parte do tempo respondendo a requisições automatizadas. A latência sobe e a conta do banco aumenta.

Uma política que costuma funcionar é misturar controle de burst (pegar picos), um teto sustentado (para justiça) e custo maior para endpoints fáceis de abusar.

Uma configuração prática:

- Burst por IP: permita 30 requisições a cada 10 segundos por IP, depois retorne 429 e um cooldown curto

- Steady por usuário: permita 120 requisições por minuto por usuário autenticado (chaveada por ID de usuário, não por IP)

- Guarda de paginação de busca: limite a profundidade (por exemplo, máximo página 20) a menos que o usuário esteja verificado

- Custo de export: trate

POST /exportcomo 10x o custo de uma busca normal - Usuários anônimos: limites menores e exija um pequeno atraso após 429s repetidos

Usuários normais raramente percebem. Eles buscam, clicam e talvez atualizem uma vez. O scraper bate o teto de burst rápido e depois encontra os tetos sustentados quando tenta continuar.

Na primeira semana, observe se os limites prejudicam mais pessoas reais do que atrasam bots. Monitore falsos positivos (quem levou 429 e onde), latência (p95 antes/depois), mudanças em 401/403/429 e 5xx a jusante, tickets de suporte de redes compartilhadas e ofensores repetidos ao longo do tempo.

Se isso roda num backend herdado gerado por IA, tenha cuidado: auth bagunçada e IDs inconsistentes tornam cotas por usuário pouco confiáveis. Conserte identidade e logging primeiro, depois aperte os limites.

Próximos passos e quando pedir ajuda

Comece pelos caminhos de maior risco e custo: fluxos de autenticação (login, reset de senha, refresh de token) e endpoints caros (busca, exports, chamadas de IA, relatórios). Faça mudanças em passos pequenos para não surpreender clientes reais. Meça o que é “normal” e aperte aos poucos.

Uma ordem de rollout segura costuma ser:

- Apenas log: registre bloqueios em potencial, sem bloquear de fato

- Limites suaves: retorne avisos ou adicione delay para usuários pesados

- Aplicação: retorne 429s claros com janelas de retry consistentes

- Ajuste: aumente limites para clientes conhecidos e reduza para automações óbvias

Escreva regras em linguagem simples: o que é limitado, a janela (por segundo/minuto/dia), o que acontece quando o limite é atingido e como pedir cota maior.

Traga ajuda quando limites sejam fáceis de contornar, usuários legítimos são bloqueados e você não consegue explicar a partir dos logs, autenticação e chaves estiverem bagunçadas (tokens compartilhados, falta de IDs de usuário), ou você suspeitar de problemas de segurança maiores (segredos expostos, injection, checks de acesso quebrados).

Se sua API começou como um protótipo gerado por IA e throttling ou auth parecem falhos, uma remediação focada costuma ser mais rápida que remendos contínuos. FixMyMess (fixmymess.ai) pode rodar uma auditoria gratuita e ajudar a reparar rate limiting, autenticação e endurecimento de segurança para deixar o projeto pronto para produção, tipicamente em 48–72 horas.

Perguntas Frequentes

Como sei se minha API está sendo abusada ou apenas ficou popular?

Comece procurando padrões que não batem com o uso normal: picos súbitos de tráfego, aumento de 429/5xx/timeouts, um endpoint sendo chamado milhares de vezes, muitas autenticações falhas ou requisições “quase válidas”. Se a latência sobe junto com o volume de requisições, trate como ataque até provar o contrário.

Qual é uma configuração “padrão” boa de limitação para uma API pública?

Use um pequeno conjunto de níveis e aplique-os por identidade: anônimo, autenticado e org/workspace. Dê à maioria dos endpoints um padrão tolerante e aperte apenas nas rotas de alto risco ou alto custo, como login, reset de senha, busca, exports e uploads.

Devo usar token bucket, leaky bucket ou fixed window?

Token bucket costuma ser o melhor padrão porque permite pequenos bursts e evita enchentes sustentadas, o que combina com o comportamento real de aplicações. Use um modelo mais rigoroso (ou um burst pequeno) para endpoints sensíveis como login ou reset de senha quando precisar de mais controle.

No que devo aplicar a limitação: IP, ID de usuário, API key ou organização?

Prefira API key, cliente OAuth ou ID de usuário para tráfego autenticado, pois isso mapeia para um cliente real. Use limites por IP principalmente para tráfego não autenticado e controle de inundações, e combine IP + key/usuário para endpoints fáceis de serem raspados.

O que minha API deve retornar quando alguém atingir um limite?

Retorne HTTP 429 com uma mensagem clara explicando o que aconteceu e quando tentar de novo. Inclua um valor Retry-After quando possível e, se der, cabeçalhos consistentes com cota restante e tempo até reset para que clientes bem comportados possam se ajustar.

Como evito tempestades de retries quando clientes recebem 429?

Torne o backoff a escolha óbvia dizendo quando o cliente pode tentar novamente e sem incentivar retries rápidos. Adicione pequenos atrasos para violações repetidas e monitore clientes com comportamento de retry em loop apertado após erros.

Como funcionam limites ponderados e quando devo usá-los?

Atribua custos maiores a endpoints caros ou comumente abusados, para que consumam cota mais rápido que leituras básicas. Isso desacelera scraping e ataques de força bruta sem punir navegação normal que toca apenas endpoints baratos.

Preciso de cotas por usuário ou por organização se já tenho limites por minuto?

Limites por minuto cortam picos, mas cotas limitam uso total no dia/mês para que um cliente não consuma tudo silenciosamente. Use unidades fáceis de entender: requisições por dia, tokens por mês ou “jobs” por ciclo de faturamento. Avise em 80%, alerte em 95% e bloqueie em 100%, mesmo sem sistema de cobrança ainda.

Onde devo aplicar limitação no meu arquitetura?

Evite impor limites apenas na memória do servidor, pois isso se quebra ao escalar ou reiniciar. Um store compartilhado como Redis é uma escolha prática comum: é rápido e suporta incrementos atômicos, evitando condições de corrida que abusers exploram.

Quais são os erros mais comuns de limitação que quebram usuários reais?

Erros frequentes incluem usar um limite global para tudo, depender só de IP, não ter visibilidade de quem está sendo bloqueado e deixar jobs internos usarem a mesma identidade que tráfego de usuário. Se seu backend foi gerado por IA e identidade/autenticação/logging estão inconsistentes, conserte isso primeiro — normalmente torna o throttling previsível. Equipes como FixMyMess podem auditar e reparar isso rapidamente quando remendos não funcionam.