Ограничение частоты API: практическое управление трафиком и защита от злоупотреблений

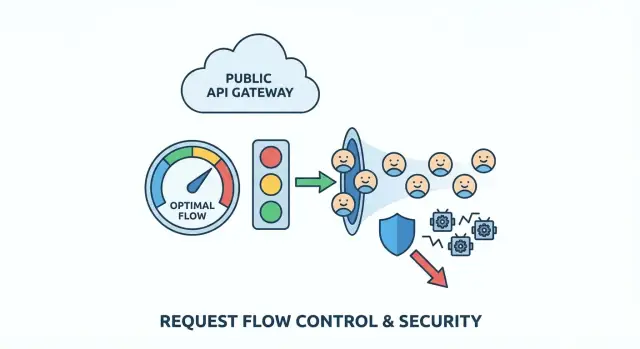

Шаблоны ограничения частоты API: как замедлять злоупотребления, останавливать ботов и назначать честные квоты на пользователей с простыми правилами, которые защищают реальных клиентов.

Какую проблему вы решаете (простыми словами)

Публичный API — это как стойка регистрации, которая никогда не закрывается. Большинство людей подходят, запрашивают что‑то одно и уходят. Злоупотребление — это когда кто‑то (или какой‑то багнутый код) начинает долбить эту стойку так часто, что остальные вынуждены ждать.

Злоупотребление редко бывает одномерным. Это может быть скрейпинг (быстрый сбор больших объёмов данных), brute‑force (подбор паролей или API‑ключей) или клиент, застрявший в цикле повторных попыток после ошибки. Иногда это не даже злонамеренно: неудачное деплой‑обновление может превратить нормальное приложение в самый громкий «атакующий» процесс.

Соблазнительно "просто заблокировать", но грубые правила наказывают реальных пользователей. Многие клиенты разделяют IP (офисы, школы, кафе). Мобильные сети меняют IP. Некоторые SDK автоматически ретраят. Если правило слишком широкое, вы блокируете не тех и всё равно пропускаете настоящего злоумышленника.

Ранние признаки обычно видны в логах и дашбордах: внезапные всплески трафика, не соответствующие норме, рост ошибок (тайм‑ауты, 429, 5xx), замедление ответов, странный набор эндпоинтов (один list‑эндпоинт вызывается тысячами раз в минуту) или множество неудачных попыток авторизации и «почти валидных» запросов.

Цель ограничения частоты API проста: сохранить доступность и предсказуемость для обычных пользователей, даже когда трафик становится беспорядочным. Хорошие лимиты замедляют плохие паттерны, дают законным клиентам понятную обратную связь и выигрывают вам время на реагирование, не сваливая весь сервис.

Нанесите на карту поверхности API и точки риска

Прежде чем выбирать числа, разберитесь, что вы защищаете. Лимитирование работает лучше, когда оно соответствует реальной структуре вашего API, а не одной общей политике.

Начните с перечисления всех публичных точек входа, доступных третьим сторонам, включая те, которые вы забываете, потому что они "кажутся внутренними" (мобильные эндпоинты, JSON‑вызовы веб‑приложения, партнёрские маршруты). Затем пометите, какие эндпоинты скорее всего будут злоупотребляться, а какие просто дорогие.

Зоны повышенного риска обычно предсказуемы: логин, регистрация, обновление токена, сброс пароля и коды верификации, дорогие поиски/фильтры, загрузки файлов или обработка медиа, а также любые административные действия, которые случайно оказались открыты.

Далее решите, на кого применяется лимит:

- Анонимный трафик часто требует лимитов по IP, но IP общие и могут меняться.

- Аутентифицированный трафик можно лимитировать по user ID, API‑ключу, OAuth‑клиенту или ID организации/пространства.

- B2B‑продуктам обычно полезны лимиты на уровне организации, чтобы один клиент не мог отобрать ресурс у всех остальных.

Чтобы не усложнять, разбейте эндпоинты по «стоимости», чтобы не относиться ко всему одинаково. Например: дешёвые чтения, обычные листинги с пагинацией, дорогие поиски/экспорт/загрузки/AI‑вызовы и критичные потоки аутентификации/паролей.

Затем опишите честное использование простыми словами. Важны ли вам короткие всплески (100 запросов за 10 секунд) или устойчивое потребление (10 000 в день)? Многие продукты нуждаются в обоих: небольшой буст для загрузки страниц и долгосрочный лимит, чтобы остановить медленный скрейпинг.

Если вы унаследовали сгенерированный ИИ API, начните с этой карты. Команды вроде FixMyMess часто находят «дорогие» эндпоинты под невинными именами и пропущенные проверки аутентификации, из‑за чего лимитирование остаётся последней линией защиты.

Выберите модель троттлинга, которая соответствует реальному трафику

Хорошее лимитирование должно быть невидимым для нормальных пользователей и очень громким для злоумышленников. Обычно это означает поддержку бурстовой активности (загрузка страниц, переподключения мобильных клиентов, ретраи) без разрешения длительного высокого объёма извлечения данных.

Основные модели (и когда они подходят)

Token bucket — распространённый выбор для хорошего UX. У каждого пользователя есть «ведро», которое со временем пополняется. Каждый запрос тратит токен. Если ведро пустеет, пользователи могут сделать короткий всплеск, а потом естественно замедлиться по мере исчерпания токенов.

Leaky bucket строже. Запросы попадают в воронку, которая стекает с постоянной скоростью. Это сглаживает всплески и защищает хрупкие бэкенды, но может казаться суровым для легитимных клиентов, которые делают нормальные быстрые последовательные запросы.

Fixed window — проще всего: "100 запросов в минуту." Подводный камень — границы окна. Клиент может выполнить 100 запросов в 12:00:59 и ещё 100 в 12:01:00, что фактически даёт 200 запросов за две секунды. Для низкорисковых эндпоинтов или как первый шаг, когда простота важнее справедливости, это часто приемлемо.

На практике многие команды стандартизуют одну модель по умолчанию и оставляют более строгую для чувствительных эндпоинтов:

- По умолчанию: token bucket для большинства read/write API

- Строже: leaky bucket (или token bucket с очень маленьким burst) для дорогих маршрутов

- Простой вариант: fixed window для малоопасных эндпоинтов

- Отдельные правила для аутентификации, поиска и массовых действий

Так политика остаётся простой и при этом защищает те маршруты, которые действительно интересуют злоумышленников.

На чём ставить лимиты (и чего избегать)

Лимитирование справедливо только насколько точен идентификатор, на который вы его ставите. Выберите неправильный «кто» — и вы будете блокировать хороших пользователей, а злоумышленники пройдут мимо.

Чистый вариант — API‑ключ (или OAuth‑клиент): он соответствует реальному клиенту и редко делится случайно. ID вошедшего пользователя тоже хороший вариант, но может запутать, когда один человек открывает много сессий или часто меняет устройства. ID организации полезен для плановых лимитов, но может скрыть одного шумного пользователя внутри большого аккаунта.

Ограничения по IP работают до входа в систему, но наказывают невинных: IP разделяются по дизайну (офисы, школы, мобильные операторы, VPN). Если опираться только на IP, одна активная машина может заблокировать целый кампус.

Более безопасный подход — комбинировать сигналы, чтобы ни один не доминировал:

- По пользователю или API‑ключу: защищает клиентов друг от друга

- По IP: ловит всплески и дешёвый бот‑трафик на ранней стадии

- По эндпоинту: строже для дорогих маршрутов (логин, поиск, экспорт)

- По организации: соблюдает план без микроменеджмента отдельных людей

Для неаутентифицированного трафика считайте риск выше. Делайте капы жёстче, но дайте легальному пользователю путь к повышенному доверию: разрешите небольшие всплески, затем замедляйте и поощряйте аутентификацию перед массовыми действиями.

Пример: для публичного search‑эндпоинта ограничивайте и по API‑ключу, и по IP. Тогда скрейпер, вращающий ключи, упирается в IP‑стену, а реальный клиент в общем офисе получает свой per‑key бюджет.

Если унаследовали код, сгенерированный ИИ, проверьте, чтобы идентификаторы были согласованными между сервисами. FixMyMess часто видит лимиты, привязанные к нестабильным значениям (например, необработанным заголовкам), из‑за чего троттлинг кажется случайным для клиентов.

Пошагово: внедряем лимиты, не ломая клиентов

Лимитирование работает лучше, когда оно предсказуемо для реальных пользователей и болезненно только для злоумышленников. Ваша цель — не блокировать трафик, а формировать его.

1) Начните с уровней и простых правил

Определите несколько уровней, соответствующих реальному использованию: анонимные посетители, вошедшие бесплатные пользователи, платные пользователи и внутренние инструменты. Первую версию сделайте простой — нюансы можно добавить позже.

2) Оценивайте эндпоинты по риску (и стоимости)

Не все запросы равны. Дорогие или чувствительные эндпоинты должны «стоить» дороже, чем простые чтения. Логин, сброс пароля, поиск и экспорт — частые мишени злоупотреблений.

Практический подход — взвешенные запросы: чтения = 1, логин = 5–10, экспорт = 50+, всё, что требует тяжёлой работы с базой — дороже. Это замедляет скрейпинг и подбор паролей, не наказывая обычную навигацию.

3) Возвращайте понятные 429 и консистентные заголовки

Когда клиент достигает лимита, отвечайте HTTP 429 и простым сообщением о том, что случилось и что делать дальше. Включайте консистентные заголовки, чтобы клиенты могли сами корректироваться: оставшаяся квота, время до сброса и Retry-After — если стек это поддерживает.

4) Давайте безопасные рекомендации по повторным попыткам

Ясно укажите, когда ретраи допустимы (короткие всплески), а когда нет (жёсткие квоты или эндпоинты вроде логина, где повторы выглядят как атака). Плохая стратегия повторов может превратить небольшой всплеск в инцидент.

5) Мониторьте и корректируйте по реальным данным

Отслеживайте, как часто пользователи попадают под лимиты, какие эндпоинты дают 429, и кто топ‑нарушители. Если вы правите сгенерированное ИИ приложение (например, прототип с сломанной аутентификацией и шумными ретраями), часто обнаруживаются клиентские циклы, которые выглядят как злоупотребление. Исправление клиента обычно уменьшает боль от лимитов больше, чем повышение самих лимитов.

Шаблоны защиты от ботов, которые не наказывают нормальных пользователей

Хорошая защита от ботов — не построение стены, а добавление небольших замедлений там, где боты получают максимальную выгоду: регистрация, сброс пароля и обновление токена. Обычные пользователи заходят туда редко, поэтому дополнительные проверки менее надоедливы.

Перед тем как бросать вызов, логируйте сигналы, которые отделяют автоматизацию от нормального поведения: всплески регистраций с одного диапазона IP, повторяющиеся неудачные логины или попытки сброса пароля, обновление токена без реального использования API, странные user‑agent или трафик, который трогает только листинги/поиски.

Используйте прогрессивные вызовы вместо мгновенного бана. Начните с понятного 429 и короткого перерыва. Если паттерн продолжается — замедлите клиента, затем временно заблокируйте (минуты, а не дни). Это снижает шанс, что вы вырубите кафе‑Wi‑Fi, где несколько реальных пользователей используют один IP.

Относитесь к подбору паролей иначе, чем к общим всплескам API. Для логина лимитируйте и по идентификатору аккаунта, и по IP, применяйте более строгие пороги на неудачные попытки. Для общего API трафика давайте более лояльные лимиты и сосредотачивайтесь на устойчивых повторяющихся паттернах.

Квоты на пользователя и правила честного использования

Минутные лимиты останавливают рывки, но не решают вопрос справедливости: кто потребляет больше со временем? Пер‑пользовательские или пер‑организационные квоты ограничивают суммарное использование за день или месяц, чтобы один тяжёлый клиент не вытеснил остальных.

Начните с понятной единицы: запросы в день, токены в месяц или «задания» за расчётный период. В командных продуктах квоты обычно на уровне организации с опциональными под‑лимитами на пользователя, чтобы один участник не мог исчерпать весь ресурс.

Мягкие лимиты предотвращают неожиданные падения. Простой паттерн: уведомлять на 80%, предупреждать на 95%, блокировать на 100%. Даже без биллинга такие пороги помогают клиентам подготовиться.

Когда кто‑то превышает квоту, ответ должен быть очевидным и действенным. Используйте понятный статус (часто 429) и включайте текущую нагрузку, лимит, время сброса и инструкцию, как запросить увеличение.

Конкретный пример: если сгенерированное ИИ приложение вышло без квот, утекающий API‑ключ может потратить недельный бюджет за часы. Команды вроде FixMyMess часто видят такое после релиза прототипа. Добавление месячных ограничений на уровне организации и ранних уведомлений обычно останавливает вред без блокировки легитимных клиентов, которым просто нужен более высокий план или временный буст.

Где живут лимиты: архитектурные решения, выдерживающие продакшен

Место, где вы применяете лимиты, так же важно, как и сами цифры. Одно и то же правило может быть надёжным или бесполезным в зависимости от того, где хранится счётчик и как он обновляется.

Большинство команд применяют лимиты в одном из этих мест:

- В памяти (на сервере): быстро и просто, но ломается при нескольких инстансах

- Redis (shared cache): распространённый дефолт, общий для инстансов, поддерживает атомарные операции

- База данных: легче для аудита, но обычно слишком медленная и дорогая для проверки на каждый запрос

- Шлюз API или функции CDN: отлично, если доступны, но могут ограничивать кастомные ключи и ответы

Если сомневаетесь, Redis плюс небольшая обёртка на стороне приложения — безопасная стартовая точка для публичных API.

Распределённые системы и мульти‑региональные реалии

В распределённых системах гонки — тихая причина сбоев. Два запроса могут одновременно пройти проверку, если инкремент‑и‑сравнение не атомарны. Используйте атомарные инкременты (или один скрипт/транзакцию) и держите ключи в согласованном виде, например userId + route + time window. Несогласованные ключи создают лазейки, которые злоумышленники быстро находят.

Мульти‑региональный трафик заставляет выбирать между строгой согласованностью и доступностью. Строгие глобальные лимиты требуют общего счётчика или сильной координации, что добавляет задержки и может приводить к закрытию сервиса при сбоях. Многие команды принимают мягкие локальные лимиты по регионам (eventual consistency), потому что это сохраняет отзывчивость API и при этом останавливает большинство злоупотреблений.

Избегайте обращения к основной базе данных только ради решения, пускать ли запрос дальше. Лимитирование должно быть быстрым чтением, а бизнес‑логика выполняться только если запрос разрешён.

Если унаследовали сгенерированный ИИ бэкенд (часто с Replit или v0), именно здесь обычно всё идёт не так: лимиты хранятся в процессе, сбрасываются на деплое и ломаются при масштабировании.

Частые ошибки и ловушки

Большинство неудачных запусков происходят не из‑за продвинутых атак. Они случаются потому, что лимиты слишком простые, грубые или невидимы после деплоя.

Обычная ловушка — один глобальный лимит и мысль, что дело сделано. Это кажется безопасным, но наказывает ваших лучших клиентов (power users, партнёров) и внутренние инструменты. Разделите классы трафика (публичный, аутентифицированный, партнёрский, внутренний) и дайте им разные потолки.

Ещё одна ошибка — опора только на IP. IP общие и меняются. Блокируя по IP, вы блокируете невинных и всё равно пропускаете распределённых ботов.

Следите за штормами повторов. Клиент получает 429, ретраит немедленно, снова получает 429 и умножает трафик в худший момент. Ваш ответ с 429 должен делать бэкофф очевидным.

Также обратите внимание на самотроттлинг: фронтенд вызывает API во время запуска, а фоновые джобы тоже синхронизируют данные. Если оба используют один ключ или токен, они начнут друг друга тормозить и вызовут случайные ошибки.

Не работайте вслепую. Если вы не видите, какие пользователи, ключи, диапазоны IP или эндпоинты вызывают троттлинг, вы не сможете настроить правила до жалоб клиентов.

Быстрый чек‑лист перед запуском

Перед тем как включить лимиты для всех, быстро проверьте места, которые обычно приносят проблемы.

- Разделите трафик минимум на два ведра: анонимный (выше риск) и вошедший (более идентифицируемый).

- Сделайте чувствительные эндпоинты строже, чем обычные чтения: аутентификация, сброс пароля, обновление токена, регистрация, и дорогие поиски/отчёты/экспорт.

- Делайте ответы 429 понятными: простым языком +

Retry-After, чтобы корректные клиенты отступали. - Добавьте мониторинг до запуска: топ нарушителей (ключ/IP/user) и наиболее блокируемые эндпоинты.

- План исключений: у службы поддержки должен быть безопасный временный путь обхода с логированием.

Пример ситуации: остановить скрейпинг, не заблокировав клиентов

У вас есть публичный поиск GET /search?q=.... Всё работало, пока скрейпер не стал перебирать все ключевые слова и комбинации фильтров весь день. Реальные пользователи всё ещё работают, но API тратит большую часть времени на автоматические запросы. Задержки растут, и ваш счёт за базу тоже.

Политика, которая часто работает: микс контроля всплесков (burst), устойчивого потолка и повышенной стоимости для легко злоупотребляемых эндпоинтов.

Практическая настройка:

- Пер‑IP burst: 30 запросов за 10 секунд на IP, затем 429 и короткий откат

- Пер‑пользовательский steady: 120 запросов в минуту на аутентифицированного пользователя (по user ID, а не по IP)

- Защита пагинации поиска: ограничение глубины (например, не более 20 страниц), если пользователь не верифицирован

- Стоимость экспорта:

POST /exportравен 10 обычным поисковым запросам - Анонимные пользователи: более низкие лимиты и требование небольшого ожидания после повторяющихся 429

Обычные пользователи этого почти не заметят: они ищут, кликают и возможно обновляют страницу. Скрейпер быстро достигнет границы burst, затем столкнётся с устойчивыми потолками при продолжении.

В первую неделю наблюдайте, мешают ли лимиты реальным людям сильнее, чем замедляют ботов. Отслеживайте ложные срабатывания (кто получил 429 и где), задержки (p95 до/после), сдвиги в 401/403/429 и downstream 5xx, тикеты поддержки из общих сетей и повторяющихся нарушителей.

Если это запускается на унаследованном сгенерированном ИИ бэкенде, будьте осторожны: сломанная аутентификация и непоследовательные пользовательские ID делают пер‑пользовательские квоты ненадёжными. Сначала исправьте идентичность и логирование, потом ужесточайте лимиты.

Следующие шаги и когда привлекать помощь

Начните с путей с наибольшим риском и стоимостью: потоки аутентификации (логин, сброс пароля, обновление токена) и дорогие эндпоинты (поиск, экспорт, AI‑вызовы, отчёты). Внедряйте изменения маленькими шагами, чтобы не удивлять реальных клиентов. Измерьте, что значит «норма», затем постепенно ужесточайте.

Порядок развёртывания, который безопасен:

- Только логирование: записывайте потенциальные блокировки, но пока не блокируйте

- Мягкие лимиты: возвращайте предупреждения или добавляйте задержку для тяжёлых пользователей

- Принудительное применение: возвращайте понятные 429 с консистентными окнами повторной попытки

- Настройка: повышайте лимиты для известных хороших клиентов, снижайте для очевидной автоматизации

Записывайте правила простым языком: что ограничено, окно (в секунду/минуту/день), что происходит при превышении и как запросить повышение.

Привлекайте помощь, когда лимиты легко обходятся, легитимные пользователи блокируются и вы не можете объяснить это из логов, аутентификация и ключи в беспорядке (общие токены, отсутствуют user ID), или есть подозрения на более серьёзные проблемы безопасности (утёкшие секреты, инъекции, сломанные проверки доступа).

Если ваш API изначально был прототипом, сгенерированным ИИ, и троттлинг или аутентификация работают плохо, сфокусированное исправление часто быстрее бесконечных заплаток. FixMyMess (fixmymess.ai) может провести бесплатный аудит и помочь исправить лимитирование, аутентификацию и укрепление безопасности, чтобы проект стал готов к продакшену в течение 48–72 часов.

Часто задаваемые вопросы

Как понять: мой API подвергается злоупотреблениям или просто стал популярным?

Начните с поиска закономерностей, которые не похожи на обычное использование: резкие всплески трафика, рост 429/5xx/тайм‑аутов, один эндпоинт обрабатывает тысячи запросов, много неудачных попыток аутентификации или повторяющиеся «почти валидные» запросы. Если задержки растут вместе с объёмом запросов, предполагайте, что вас штурмуют, пока не доказано обратное.

Какой «дефолтный» набор ограничений подходит для публичного API?

Используйте небольшое количество уровней и привязывайте их к идентичности: анонимные, аутентифицированные и организация/пространство работ. Дайте большинству эндпоинтов щадящие настройки по умолчанию и ужесточайте правила только для рискованных или дорогостоящих маршрутов: логин, восстановление пароля, поиск, экспорт и загрузки.

Что выбрать: token bucket, leaky bucket или fixed window?

Token bucket обычно лучший выбор по умолчанию: он позволяет короткие всплески, но не даёт устойчивого потока. Для особо чувствительных операций (логин, восстановление пароля) используйте более строгую модель или очень маленький burst.

На чём лучше ставить лимиты: IP, user ID, API key или организация?

Для аутентифицированного трафика предпочитайте API‑ключ, OAuth‑клиент или ID пользователя — они соответствуют реальному клиенту. Ограничения по IP разумны для неаутентифицированного трафика и для раннего обнаружения флуд‑атак, а для уязвимых эндпоинтов комбинируйте IP и ключ/ID.

Что должен возвращать API, когда кто‑то превысил лимит?

Возвращайте HTTP 429 с понятным сообщением о том, что лимит превышен и когда можно повторить. По возможности включайте Retry-After и консистентные заголовки с оставшимся квотированием и временем сброса, чтобы корректно реализующие клиенты могли сами снизить скорость.

Как избежать штормов повторных запросов после 429?

Сделайте экспоненциальный или линейный бэкофф очевидным: указывайте, когда можно повторить, и не поощряйте немедленные быстрые повторы. Добавляйте небольшие задержки при повторных нарушениях и следите за клиентами с ошибочным поведением, которые в цикле повторяют запросы после ошибок.

Как работают взвешенные лимиты и когда их использовать?

Поднимайте «стоимость» дорогих эндпоинтов: логин, экспорт, тяжёлые поиски должны сжигать квоту быстрее, чем обычное чтение. Это замедляет скрейпинг и перебор паролей, не наказывая простую навигацию по сайту.

Нужны ли пер‑пользовательские или пер‑организационные квоты, если у меня уже есть минутные лимиты?

Минутные лимиты останавливают всплески, но не решают проблему долгого потребления. Квоты по дню или месяцу ограничивают суммарное потребление, чтобы один клиент не съел весь ресурс. Делайте пороги понятными: уведомление на 80%, предупреждение на 95%, блок на 100%.

Где лучше реализовать ограничение: в памяти, в Redis или в базе данных?

Не храните счётчики только в памяти сервера — при масштабировании или перезапуске они слетают. Redis — распространённый практический выбор: быстрый, разделяемый, поддерживает атомарные инкременты и скрипты, чтобы избегать гонок.

Какие распространённые ошибки при лимитировании ломают реальных пользователей?

Типичные ошибки: одна глобальная политика для всего трафика, опора только на IP, отсутствие видимости того, кто именно попадает под throttle, и использование тех же удостоверений для фоновых задач и пользовательского трафика. Если бэкенд сгенерирован ИИ и идентификация/логи нестабильны, сначала поправьте эти основы — это сделает лимитирование предсказуемым. Команды вроде FixMyMess могут быстро провести аудит и починить такие проблемы.