Du prototype à la production en 72 heures : un plan de stabilisation

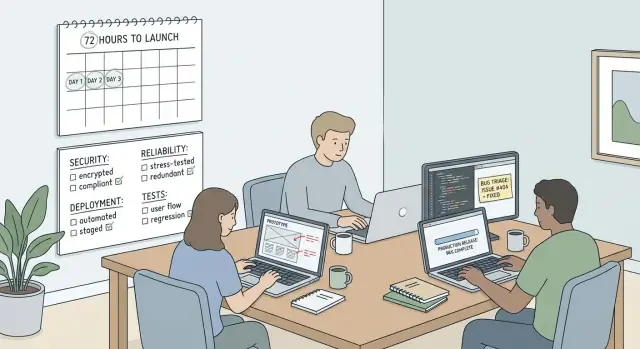

Prototype en production en 72 heures : une checklist phasée réaliste pour la sécurité, la fiabilité, le déploiement et des tests minimaux pour livrer en toute sécurité.

Que signifie vraiment « prêt pour la production en 72 heures »

Pour une première release, « prêt pour la production » ne veut pas dire parfait. Cela signifie que l’application est sûre à utiliser, prévisible en usage normal et récupérable quand quelque chose casse.

Livrer un prototype tel quel est risqué parce que les prototypes cachent souvent des arêtes vives : secrets en dur, authentification faible, contrôles d’accès manquants et gestion des données bancale. Même si l’interface a l’air finie, une seule requête malformée peut divulguer des données utilisateur, corrompre des enregistrements ou faire chuter l’app. Le coût n’est pas que des bugs. C’est la perte de confiance, du temps gaspillé et parfois des problèmes légaux et de conformité.

Une poussée réaliste de 72 heures se concentre sur la stabilisation d’un chemin utilisateur central et la réduction des inconnues. Vous ne courez pas après tous les cas limites. Vous vous assurez que le parcours principal fonctionne, échoue de façon sûre et peut être déployé et surveillé sans surprises.

Pour une première release, « suffisamment prêt pour la production » ressemble en général à ceci :

- Pas de secrets exposés, contrôles de sécurité basiques en place et contrôle d’accès clair

- Un flux principal fonctionne de bout en bout, avec validation des entrées et erreurs utiles

- Les modifications de données sont sûres (pas de perte silencieuse, pas d’actions destructrices sans confirmation)

- Visibilité minimale (logs lisibles, signaux clairs quand quelque chose casse)

- Un processus de déploiement répétable et un plan de rollback simple

Ce qui peut attendre : gros refactors, nettoyages de style, travail large sur les fonctionnalités et une suite de tests complète. Ils sont importants, mais peuvent consommer les 72 heures sans réduire les plus grands risques.

Choisissez le flux principal que vous devez livrer en sécurité

Si vous essayez de « tout réparer » en 72 heures, vous ne livrez rien. Le chemin le plus rapide consiste à choisir un flux principal qui doit fonctionner à chaque fois, même quand ça va mal.

Écrivez les 3 à 5 actions qu’un utilisateur réel doit accomplir de bout en bout. Restez simple et testable :

- Créer un compte et vérifier l’email

- Se connecter et réinitialiser le mot de passe

- Créer l’élément principal (projet, ticket, facture, post)

- Payer ou démarrer un essai (si vous facturez)

- Exporter, télécharger ou partager le résultat

Puis marquez où des données sensibles sont manipulées : mots de passe, détails de paiement, uploads, clés API, outils admin, et tout ce qui pourrait exposer des données clients. Si des secrets vivent dans le navigateur, des tokens apparaissent dans les logs ou vous envoyez une clé de base de données publique, le flux n’est pas sûr à publier.

Définissez le critère de « terminé » avant que qui que ce soit commence à patcher du code. Vous n’avez pas besoin d’un long cahier des charges, juste une barre claire :

- Fonctionne avec un compte vierge et des entrées réalistes

- Messages d’erreur clairs et solutions de repli sûres (pas d’écrans vides)

- Logging basique des échecs

- Pas de trous évidents dans l’auth et l’accès aux données

- Quelqu’un peut déployer deux fois de suite sans surprises

Enfin, décidez ce qui est hors scope. Nouvelles fonctionnalités, refontes visuelles, paramètres « sympa à avoir » et optimisation des performances peuvent attendre.

Heure 0–3 : un audit rapide pour faire remonter les risques évidents

Les trois premières heures servent à comprendre ce que vous avez réellement et ce qui peut vous nuire vite.

Commencez par confirmer les environnements. Beaucoup de prototypes confondent local, staging et production, ou réutilisent la même base de données entre eux. Notez quelle URL et quelle base de données chaque environnement utilise, et qui y a accès. Si le staging est public, traitez-le comme de la production.

Ensuite, inventairez toutes les intégrations dont l’app dépend en vérifiant les fichiers de config et les dashboards de service. Items typiques :

- Auth (connexion par email, Google, magic links)

- Base de données et migrations

- Envoi d’email/SMS

- Paiements et webhooks

- Stockage de fichiers (uploads, avatars, reçus)

Faites ensuite un scan rapide des secrets. Cherchez des clés API dans le repo, la config côté client, les logs de build, du terminal collé dans des tickets ou des captures d’écran dans la doc. Une erreur fréquente est de mettre une clé dans le code frontend « juste pour l’instant » et d’oublier qu’elle est envoyée à chaque navigateur.

Terminez l’audit par une courte liste de risques classés : qu’est-ce qui peut causer le plus de dégâts, le plus rapidement ? Exemples : des utilisateurs voient les données d’autres utilisateurs, la réinitialisation de mot de passe peut être abusée, des actions admin sont accessibles sans vérification, un paiement est marqué « payé » sans confirmation, ou un webhook peut être rejoué.

Si le prototype utilise une URL de base de données partagée partout, supposez que quelqu’un testera sur staging et effacera les données de production. La séparation des environnements remonte en tête des priorités.

Phase 1 (Jour 1) : impératifs de sécurité avant toute release

Le jour 1 vise à bloquer les voies évidentes par lesquelles votre app peut être compromise. Vous ne visez pas la « sécurité parfaite ». Vous visez « rien de gênant ou catastrophique ».

1) Sécurisez les secrets (supposez qu’ils sont déjà compromis)

Les prototypes générés par IA contiennent souvent des clés dans le repo, dans le frontend ou dans les logs. Traitez chaque clé utilisée pendant le prototypage comme compromis.

Faites ceci en priorité :

- Rotatez les clés (base de données, email, paiements, OAuth) et révoquez les anciennes

- Déplacez les secrets vers la configuration côté serveur (jamais dans le bundle client)

- Restreignez les scopes et les domaines autorisés quand c’est possible

- Vérifiez logs, outils d’erreur et docs/captures d’écran partagées pour des tokens exposés

Confirmez aussi que l’utilisateur de la base de données n’est pas un admin tout-puissant. Donnez-lui seulement les permissions nécessaires à l’application.

2) Corrigez les bases de l’auth avant toute autre chose

La plupart des incidents viennent d’un traitement faible de l’auth, pas d’exploits avancés. Assurez-vous que les pages protégées et les routes API requièrent une session valide.

Vérifications rapides :

- Routes protégées : faites la vérification côté serveur, pas seulement dans l’UI

- Gestion de session : cookies sécurisés ou tokens courts, et comportement de logout clair

- Réinitialisation de mot de passe : usage unique, courte durée d’expiration, et ne pas révéler si un email existe

Si vous stockez des tokens tiers (stockage, CRM, etc.), stockez-les côté serveur et limitez leur scope.

3) Validez les entrées côté serveur (surtout argent et identité)

Ne faites pas confiance au navigateur. Ajoutez des validations côté serveur pour les endpoints qui créent des comptes, réinitialisent des mots de passe, prennent des paiements, uploadent des fichiers ou écrivent dans la base. Préférez des allow-lists (ce que vous acceptez) aux deny-lists.

4) Bloquez les vulnérabilités courantes des prototypes

Cherchez des requêtes SQL construites en concaténant des chaînes, des uploads de fichiers non sécurisés, des redirections ouvertes après login et des endpoints qui acceptent des URLs ou des chemins de fichiers bruts. Par exemple, un returnUrl non fiable peut rediriger les utilisateurs vers un site de phishing.

Phase 2 (Jour 2) : fiabilité et gestion des échecs

Le jour 2 vise à faire en sorte que l’app se comporte bien quand de vrais utilisateurs font des choses imprévisibles. Le but est d’éviter les échecs silencieux, prévenir les mauvaises données et simplifier la récupération.

Commencez par le traitement des erreurs. Chaque échec doit faire deux choses :

- afficher à l’utilisateur une étape suivante claire, et

- écrire un log serveur sûr que vous pouvez utiliser pour déboguer.

Évitez de divulguer des secrets ou des traces de pile au navigateur. Un bon message est simple : ce qui s’est passé, quoi essayer ensuite et si le support doit intervenir.

Ensuite, empêchez la corruption des données. Les soumissions en double sont courantes (double clics, refresh, réseaux instables). Pour tout ce qui crée des enregistrements ou facture de l’argent, rendez l’action idempotente. Utilisez un id ou une contrainte unique pour qu’une même action ne puisse pas s’exécuter deux fois.

Maîtrisez les appels externes. Ajoutez des timeouts pour les paiements, les emails et les API tierces. Les retries doivent être limités et backing-off ; sinon une brève panne devient une inondation de requêtes répétées.

Une courte checklist de fiabilité suffit souvent :

- Ne pas crasher sur des enregistrements manquants (retournez des 404, utilisez des valeurs par défaut sûres)

- Dédupliquez les actions de « création » et de paiement (clés d’idempotence, contraintes uniques)

- Ajoutez des timeouts et des solutions de repli pour les appels externes

- Limitez les retries et faites remonter les échecs dans les logs/alertes

- Épinglez les versions runtime et des paquets pour réduire les surprises de déploiement

Avant d’en avoir besoin, rédigez un plan de rollback exécutable sous stress : redéployer la build précédente, revert du dernier commit ou désactiver un feature flag.

Phase 3 (Jour 3) : préparation du déploiement sans surprises

Le jour 3 vise la répétabilité. Si vous ne pouvez pas écrire les étapes exactes pour déployer, vous n’avez pas de plan de déploiement.

Choisissez une cible de déploiement pour la première release et gardez-la simple. L’objectif est une procédure que vous pouvez reproduire exactement à chaque fois.

Rédigez une courte « recette de déploiement » qui répond à :

- Que construisons-nous ?

- Que lançons-nous ?

- Qu’est-ce qui doit exister en premier (base de données, stockage, queues) ?

Confirmez les prérequis tôt : variables d’environnement, le port d’écoute de l’app et les étapes ponctuelles comme les migrations de base.

Traitez les migrations comme une release à part. Sauvegardez d’abord. Préférez des changements non destructifs (ajout de colonnes, éviter de supprimer des tables) pour pouvoir rollbacker sans perdre de données.

Mettez en place une visibilité basique avant l’envoi. Vous n’avez pas besoin d’une configuration de monitoring compliquée, mais vous devez avoir des réponses quand quelque chose casse :

- Logs centralisés pour erreurs d’app et jobs background

- Au moins une alerte pour une montée des erreurs ou une indisponibilité

- Secrets définis sur l’hôte (pas en dur dans le repo)

- Health checks (l’app démarre proprement et peut se connecter à la DB)

- Une étape de rollback écrite et la personne qui peut l’exécuter

Faites une répétition générale, puis répétez

Faites une répétition en staging avec exactement les mêmes étapes que vous utiliserez en production. Puis répétez les mêmes étapes en production, sans « petites différences ». Les variables manquantes (comme DATABASE_URL) se détectent facilement en staging et sont pénibles à découvrir en production.

Tests minimaux qui comptent (pas une suite complète)

Dans une poussée de 72 heures, le testing a un seul objectif : prévenir les échecs effrayants. Vous n’avez pas besoin de dizaines de tests de cas limites. Il vous faut un petit ensemble qui attrape rapidement les régressions dangereuses.

Choisissez votre flux principal, puis ajoutez quelques vérifications autour qui prouvent que l’app est sûre et ne ment pas.

Un bon ensemble de départ (5 à 8 vérifications au total) :

- Test smoke du flux principal : signup/login et l’action principale (création d’un enregistrement, envoi d’un message, génération d’un rapport ou checkout)

- Vérification des permissions : les utilisateurs déconnectés ne peuvent pas accéder à l’action principale ; les utilisateurs normaux ne peuvent pas accéder aux pages admin

- Vérification d’isolation des données : un utilisateur ne peut pas voir les données d’un autre en changeant un ID ou une URL

- Vérification de sécurité des entrées : les payloads invalides échouent proprement sans traces de pile

- Endpoint de health check : confirme que l’app peut servir des requêtes et atteindre les dépendances clés

Ces tests doivent être ennuyeux : rapides, répétables et faciles à lire.

Exécutez-les aux moments importants : avant de merger des changements risqués, avant de déployer (en staging avec des paramètres proches de la production) et immédiatement après le déploiement en production.

Un planning pas à pas pour 72 heures de stabilisation

Une poussée de 72 heures fonctionne mieux quand vous la traitez comme un sprint d’opérations, pas un sprint de fonctionnalités. Votre but est une version sûre, une façon claire de la vérifier et une façon claire de l’annuler.

- Heure 0–3 (kickoff) : Geler les nouvelles fonctionnalités, choisir un responsable de release, définir le « terminé » et rédiger une courte checklist de release.

- Jour 1 (sécurité) : Rotatez et sécurisez les secrets, retirez les clés en dur, corrigez l’auth et les permissions sur le flux principal, et ajoutez des validations côté serveur.

- Jour 2 (fiabilité) : Rendez les échecs prévisibles. Ajoutez timeouts, retries sûrs, erreurs utilisateurs claires et logging des événements clés.

- Jour 3 (déploiement) : Répétition du déploiement, validez les migrations, exécutez les smoke tests et planifiez une fenêtre de lancement contrôlée avec une responsabilité de support claire.

Avant de déployer, gardez une checklist que vous utiliserez vraiment :

- Migrations appliquées et réversibles

- Variables d’environnement requises présentes (et non vides)

- Secrets stockés en sécurité (pas dans le code ou les logs)

- Smoke tests passés en environnement live

- Méthode de rollback confirmée et assignée

Définissez une règle « stop the line ». Si la connexion échoue, si les 500% montent ou si les paiements ne se terminent pas, rollbackez d’abord et enquêtez ensuite.

Utilisez une note d’incident d’un paragraphe pour communiquer vite :

What happened:

Impact (who/what is affected):

When it started:

What we did (rollback/mitigation):

Next update time:

Pièges courants qui font dérailler une poussée de 72 heures

Le moyen le plus rapide de rater le délai est de traiter la stabilisation comme du travail de fonctionnalité. Une « petite amélioration » touche souvent les parties fragiles que vous essayez de sécuriser.

Pièges fréquents :

- Faire confiance aux contrôles côté client pour la sécurité (le serveur doit faire respecter permissions et validations)

- Supposer que les secrets vont bien parce que l’app fonctionne encore (si des clés ont été dans un repo, des logs ou des docs partagées, rotatez-les)

- Déployer sans un endroit sûr pour tester et sans moyen de revenir en arrière (staging et rollback gardent les erreurs petites)

- Confondre « pas d’erreurs console » avec « sûr » (beaucoup de pannes réelles arrivent côté serveur)

Un prototype peut paraître correct en demo et avoir quand même un endpoint qui permet à n’importe qui de modifier les données d’un autre utilisateur. Ça n’apparaît pas dans la console. Le corriger est souvent rapide, mais seulement si vous arrêtez d’ajouter des fonctionnalités et vous concentrez sur les bases.

Vérifications rapides avant d’appuyer sur déployer

Juste avant la release, ralentissez pendant 15 minutes. C’est là que « ça marchait hier » foire souvent.

Sécurité :

- Pas de clés de test, d’utilisateurs de démo ou de routes debug

- Secrets rotatés si jamais présents dans un repo, chat, logs ou captures d’écran

- Déconnectez-vous et confirmez que les pages et APIs protégées bloquent vraiment l’accès

Fiabilité :

- Forcez une erreur (mauvais mot de passe, entrée invalide, réseau lent) et confirmez que l’app échoue poliment

- Confirmez que les double clics ne créent pas de doublons ni de doubles prélèvements

- Assurez-vous que les retries s’arrêtent rapidement et que les échecs remontent dans les logs

Déploiement :

- Répétez les étapes de déploiement en staging exactement comme en production

- Lancez les migrations en staging et confirmez que l’app démarre et peut lire/écrire des données

- Confirmez que les logs sont visibles et qu’au moins une alerte existe

Assignez un responsable humain pour les premières heures après le lancement. « On call » peut être un fondateur avec notifications activées.

Exemple : transformer un prototype IA bancal en première release sûre

Un fondateur non technique a une web app générée par un outil IA. Elle a belle allure en local, les inscriptions de démo fonctionnent et les paiements « semblent okay ». Après le déploiement, ça tangue : des utilisateurs sont renvoyés à l’écran de login, un webhook se déclenche deux fois et une clé apparaît dans le bundle client.

Le jour 1 se concentre sur les plus gros problèmes de sécurité. L’audit trouve une clé API exposée dans le frontend, une vérification CSRF manquante sur un endpoint de session et une redirection d’auth cassée parce que l’URL de callback en production ne correspond pas aux réglages du provider d’identité. Les corrections sont directes : déplacer les secrets dans des vars d’environnement serveur, verrouiller les redirections par allow-list et vérifier les sessions sur chaque requête.

Le jour 2 porte sur la fiabilité. Le webhook d’abonnement timeoute et retrye, créant des doublons. L’app plante aussi quand une var d’environnement manque. L’équipe déduplique les webhooks par event ID, ajoute des timeouts et des règles de retry claires, renvoie des erreurs amicales plutôt que des pages vides, logge les flux clés et valide les vars requises au démarrage.

Le jour 3 rend le déploiement prévisible. L’équipe ajoute un court script de smoke-test (s’inscrire, se connecter, accomplir une action principale, confirmer le traitement des webhooks), épingle les versions runtimes et note les vars d’environnement de production requises.

Après le lancement, ils documentent ce qui reste risqué (rate limiting, règles d’autorisation plus fines) et planifient un sprint de renforcement.

Si vous avez hérité d’un codebase généré par IA avec des outils comme Lovable, Bolt, v0, Cursor ou Replit et devez le corriger rapidement, FixMyMess sur fixmymess.ai propose un audit de code gratuit pour faire remonter les vrais bloqueurs de release. Ils se concentrent sur le diagnostic et la réparation de la logique cassée, des failles de sécurité et des problèmes de déploiement pour qu’un prototype instable devienne une première release sûre.